Spark Core案例实操(四)

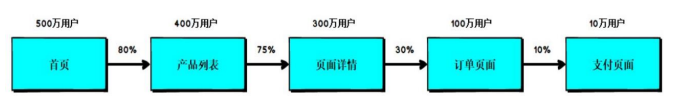

一、需求页面单跳转换率统计需求说明计算页面单跳转化率,什么是页面单跳转换率,比如一个用户在一次 Session 过程中 访问的页面路径 3,5,7,9,10,21,那么页面 3 跳到页面 5 叫一次单跳,7-9 也叫一次单跳, 那么单跳转化率就是要统计页面点击的概率。比如:计算 3-5 的单跳转化率,先获取符合条件的 Session 对于页面 3 的访问次数(PV) 为 A,然后获取符合条件...

Spark Core案例实操(三)

一、需求Top10 热门品类中每个品类的 Top10 活跃 Session 统计说明在上个需求的基础上,增加每个品类用户 session 的点击统计二、功能实现2.1 实现步骤1.过滤原始数据,保留点击和前10品类ID 2.根据品类ID和sessionId进行点击量的统计 3.将统计的结果进行结构的转换 (( 品类ID,sessionId ),sum) => ( 品类ID,(sessi...

Spark Core案例实操(二)

前言本篇根据Spark Core案例实操(一)中需求继续对代码进行优化,减少shuffle,提高性能。五、实现方案三在方案一和二中,reduceByKey算子使用过多,因为reduceByKey在进行聚合时也会存在shuffle,影响代码的整体性能。5.1 分析在读取数据之后直接转换成如下结构:点击的场合 : ( 品类ID,( 1, 0, 0 ) ) 下单的场合 : ( 品类ID,( 0, ...

Spark Core案例实操(一)

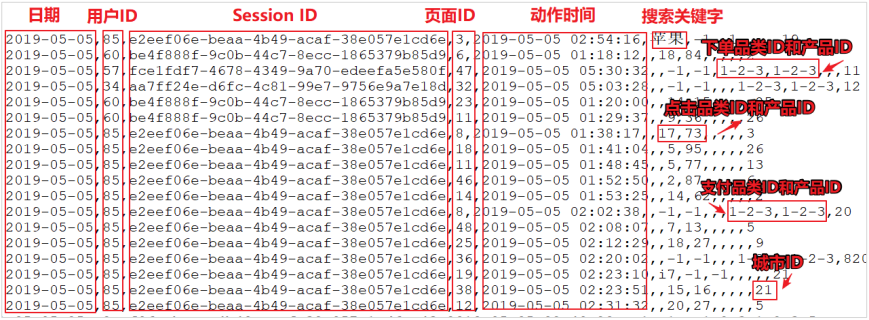

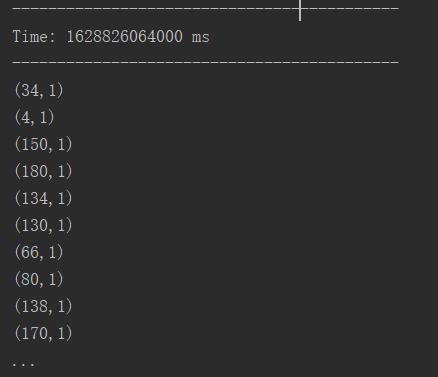

前言本篇将根据电商真实需求,进行案例实操一、数据准备上面的数据图是从数据文件中截取的一部分内容,表示为电商网站的用户行为数据,主要包含用户的 4 种行为:搜索,点击,下单,支付。数据规则如下:数据文件中每行数据采用下划线分隔数据每一行数据表示用户的一次行为,这个行为只能是4 种行为的一种如果搜索关键字为 null,表示数据不是搜索数据如果点击的品类 ID 和产品 ID 为-1,表示数据不是点...

07.DStream优雅关闭

[TOC]前言流式任务需要 7*24 小时执行,但是有时涉及到升级代码需要主动停止程序,但是分布式程序,没办法做到一个个进程去杀死,所有配置优雅的关闭就显得至关重要了。一、概念非优雅关闭两种方式:kill -9 processIdyarn -kill applicationId弊端:由于Spark Streaming是基于micro-batch机制工作的,按照间隔时间生成RDD,如果在间隔期...

06.DStream输出

[TOC]一、概念 输出操作允许DStream的操作推到如数据库、文件系统等外部系统中。因为输出操作实际上是允许外部系统消费转换后的数据,它们触发的实际操作是DStream转换。与 RDD 中的惰性求值类似,如果一个 DStream 及其派生出的 DStream 都没有被执行输出操作,那么这些 DStream 就都不会被求值。如果 StreamingContext 中没有设定...

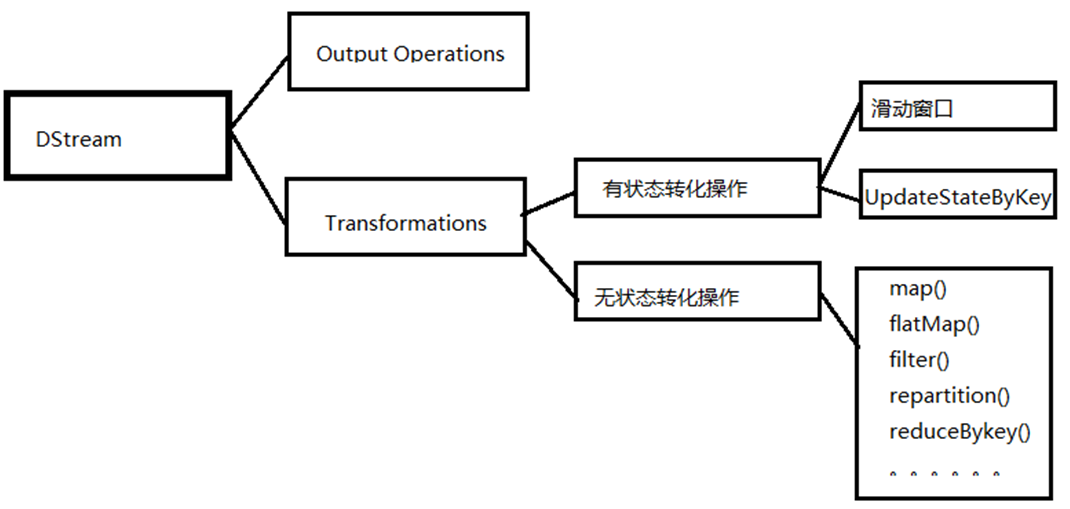

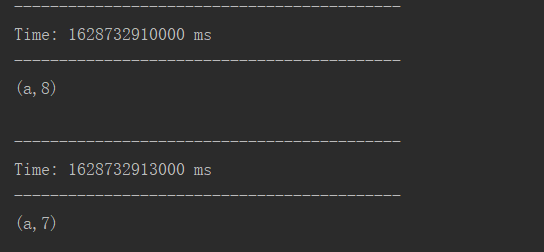

05.DStream转换

[TOC]一、概念DStream的原语与RDD类似,分分为转换(Transformation)和输出(Output)两种,此外还有一些特殊的原语,如:updateStateByKey,transform以及各种窗口(window)相关的原语。转换分类:DStream转换操作包括无状态转换和有状态转换。无状态转换:每个批次的处理不依赖于之前批次的数据。有状态转换:当前批次的处理需要使用之前批次...

04.SparkStreaming之Kafka数据源

[TOC]一、概述1.1 概念kafka作为一个实时的分布式消息队列,实时的生产和消费消息,这里我们可以利用SparkStreaming实时计算框架实时地读取kafka中的数据然后进行计算。1.2 创建DStream方式在spark1.3版本后,kafkaUtils里面提供了两个创建dstream的方法:KafkaUtils.createDstream(需要receiver接收)Receiv...

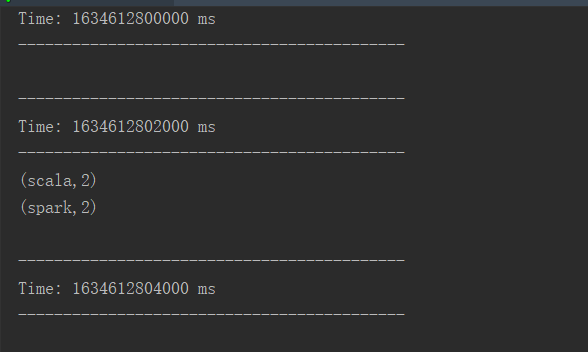

03.DStream创建

[TOC]一、RDD队列1.1 用法及说明 测试过程中,可以通过使用 ssc.queueStream(queueOfRDDs)来创建 DStream,每一个推送到 这个队列中的 RDD,都会作为一个 DStream 处理。1.2 案例实操需求循环创建几个RDD,将 RDD放入队列。通过SparkStream创建Dstream,计算WordCount。实现代码import or...