李林超博客

首页

归档

留言

友链

动态

关于

归档

留言

友链

动态

关于

首页

大数据

正文

Spark Standalone模式搭建

Leefs

2021-03-06 PM

2052℃

0条

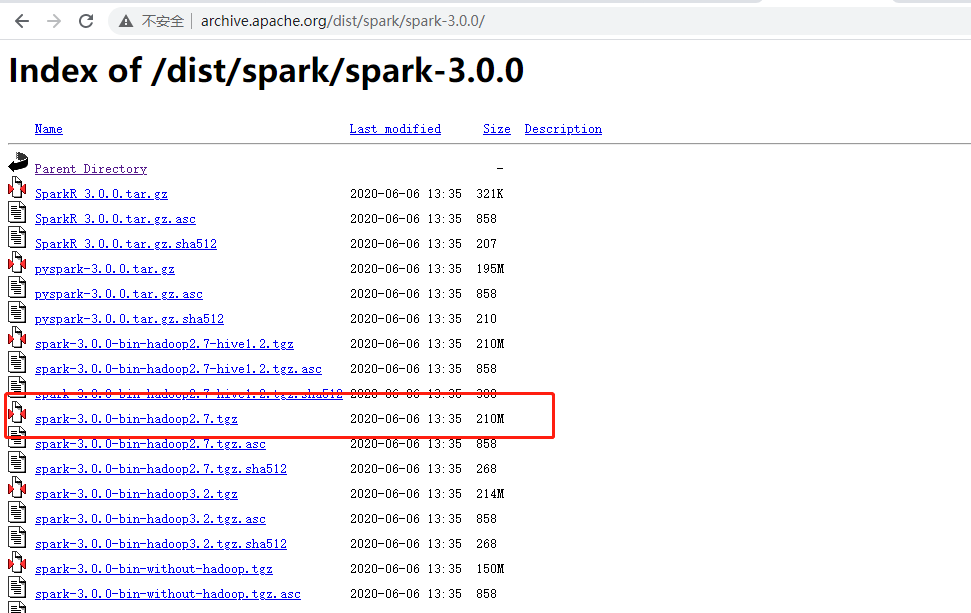

# 10.Spark Standalone模式搭建 ### 前言 搭建 Spark 集群前,需要保证 JDK 环境、Zookeeper 集群和 Hadoop 集群已经搭建,相关步骤可以参阅: + Zookeeper集群环境搭建 + Hadoop集群环境搭建 ### 一、集群介绍 这里搭建一个 3 节点的 Spark 集群,其中三台主机上均部署 `Worker` 服务。同时为了保证高可用,除了在 hadoop001 上部署主 `Master` 服务外,还在 hadoop002 和 hadoop003 上分别部署备用的 `Master` 服务,Master 服务由 Zookeeper 集群进行协调管理,如果主 `Master` 不可用,则备用 `Master` 会成为新的主 `Master`。 | | Master | Worker | Zookeeper | | --------- | ------ | ------ | --------- | | hadoop001 | 是 | 是 | 是 | | hadoop002 | 是 | 是 | 是 | | hadoop003 | 否 | 是 | 是 | ### 二、Spark集群搭建 **1. 下载** 下载地址:http://archive.apache.org/dist/spark/ 根据自身需要下载相应版本,本次下载的版本为`spark-3.0.0-bin-hadoop2.7.tgz`  **2. 上传到服务器指定目录并解压** ``` [root@hadoop001 source]# tar -zxvf spark-3.0.0-bin-hadoop2.7.tgz -C /data/soft/ ``` **3. 配置环境变量** ``` [root@hadoop001 source]# vim /etc/profile ``` 添加环境变量 ``` export JAVA_HOME=/data/soft/jdk1.8 export HADOOP_HOME=/data/soft/hadoop-3.2.1 export SPARK_HOME=/data/soft/spark-3.0.0-bin-hadoop2.7 export PATH=.:$JAVA_HOME/bin:$HADOOP_HOME/bin:$SPARK_HOME/bin:$PATH ``` 使配置生效 ``` [root@hadoop001 source]# source /etc/profile ``` **4. 集群配置** **修改spark-env.sh** ``` [root@hadoop001 source]# cd /data/soft/spark-3.0.0-bin-hadoop2.7/conf/ [root@hadoop001 conf]# cp spark-env.sh.template spark-env.sh ``` 增加如下内容: ```sh # 配置JDK安装位置 JAVA_HOME=/data/soft/jdk1.8 # 配置hadoop配置文件的位置 HADOOP_CONF_DIR=/data/soft/hadoop-3.2.1/etc/hadoop # 配置zookeeper地址 SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=hadoop001:2181,hadoop002:2181,hadoop003:2181 -Dspark.deploy.zookeeper.dir=/spark" ``` 修改slaves ``` [root@hadoop001 conf]# cp slaves.template slaves ``` 配置所有 Woker 节点的位置: ``` hadoop001 hadoop002 hadoop003 ``` **5. 安装包分发** 将 Spark 的安装包分发到其他服务器,分发后建议在这两台服务器上也配置一下 Spark 的环境变量。 ``` [root@hadoop001 conf]# scp -rq /data/soft/spark-3.0.0-bin-hadoop2.7/ hadoop002:/data/soft/ [root@hadoop001 conf]# scp -rq /data/soft/spark-3.0.0-bin-hadoop2.7/ hadoop003:/data/soft/ ``` ### 三、启动集群 **1. 启动Zookeeper集群** 分别到三台服务器上启动 ZooKeeper 服务: ``` [root@hadoop001 zookeeper-3.4.14]# /data/soft/zookeeper-3.4.14/bin/zkServer.sh start ``` **2. 启动Hadoop集群** ``` [root@hadoop001 ~]# cd /data/soft/hadoop-3.2.1/ [root@hadoop001 hadoop-3.2.1]# sbin/start-all.sh ``` **3. 启动Spark集群** ``` [root@hadoop001 conf]# cd /data/soft/spark-3.0.0-bin-hadoop2.7/sbin/ [root@hadoop001 sbin]# start-all.sh ``` 分别在 hadoop002 和 hadoop003 上执行下面的命令,启动备用的 `Master` 服务: ``` [root@hadoop002 ~]# cd /data/soft/spark-3.0.0-bin-hadoop2.7/sbin/ [root@hadoop002 sbin]# start-master.sh ``` **4. 查看服务** 查看 Spark 的 Web-UI 页面,端口为 `8080`。

标签:

Hadoop

,

Spark

非特殊说明,本博所有文章均为博主原创。

如若转载,请注明出处:

https://lilinchao.com/archives/1214.html

上一篇

Zookeeper集群环境搭建

下一篇

Spark运行架构

评论已关闭

栏目分类

随笔

2

Java

326

大数据

229

工具

31

其它

25

GO

47

NLP

4

标签云

Golang基础

Spark RDD

Spark

Java编程思想

机器学习

递归

Hive

SQL练习题

数据结构

NIO

容器深入研究

Thymeleaf

Linux

Spark Core

二叉树

Tomcat

Netty

持有对象

Http

MyBatis

Java阻塞队列

Java工具类

Docker

Sentinel

Map

FastDFS

链表

数据结构和算法

并发线程

Elastisearch

友情链接

申请

范明明

庄严博客

Mx

陶小桃Blog

虫洞

评论已关闭