李林超博客

首页

归档

留言

友链

动态

关于

归档

留言

友链

动态

关于

首页

大数据

正文

CentOS7 Hadoop安装教程

Leefs

2021-02-12 PM

2955℃

0条

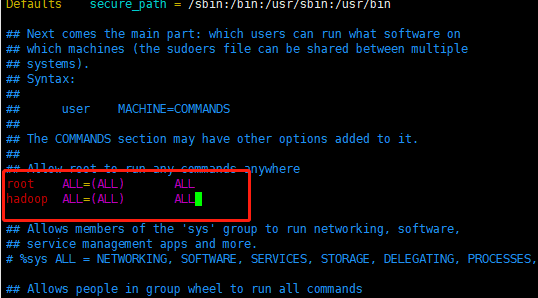

# 04.CentOS7 Hadoop安装教程 ### 前言 本次安装系统环境CentOS7.X,Hadoop版本2.5.8。 同时,环境中需要安装JDK1.8作为Hadoop的运行环境 ### 安装步骤 **一、Hadoop下载地址** https://www-eu.apache.org/dist/hadoop/common/hadoop-2.8.5/hadoop-2.8.5.tar.gz **二、创建一个新用户** **(1)添加用户** ``` [root@localhost home]# useradd -m hadoop -s /bin/bash ``` **(2)修改密码** ``` [root@localhost home]# passwd hadoop ``` **(3)分配用户组** ``` [root@localhost home]# usermod -a -G hadoop hadoop ``` **(4)添加sudo权限** ``` [root@localhost home]# vim /etc/sudoers ``` 在文件中找到“root ALL=(ALL) ALL”,在这行下面加上“hadoop ALL=(ALL) ALL”,然后输入":wq!"保存退出  **(5)切换用户** ``` [root@localhost home]# su - hadoop ``` **(6)ssh密钥生成** 检查您是否可以在没有密码的情况下ssh到localhost ``` [hadoop@localhost ~]$ ssh localhost ```  上图是需要密码! **如果需要密码执行下方命令** ``` [hadoop@localhost ~]$ ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa [hadoop@localhost ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys [hadoop@localhost ~]$ chmod 0600 ~/.ssh/authorized_keys ```  **验证是否成功** ``` [hadoop@localhost ~]$ ssh localhost ``` **(8)添加hosts** ``` [hadoop@localhost ~]$ ip addr #查看本机IP地址 [hadoop@localhost ~]$ sudo vim /etc/hosts ``` 加入 ``` #IP 主机名 192.168.159.135 hadoopserver ``` ### 三、安装步骤 安装Hadoop(伪分布式) **1、解压下载好的Hadoop** ``` [hadoop@localhost sources]$ sudo tar -zxf hadoop-2.8.5.tar.gz -C /usr/local/ ``` **2、修改文件的所有者** ``` [hadoop@localhost local]$ sudo chown -R hadoop:hadoop /usr/local/hadoop-2.8.5 ``` **3、添加环境变量** 修改`~/.bashrc`文件 ``` [hadoop@localhost local]$ vim ~/.bashrc ``` 文件中加入如下指令 ``` export HADOOP_HOME=/usr/local/hadoop-2.8.5 export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export YARN_CONF_DIR=$HADOOP_HOME/etc/hadoop export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH ``` 使环境变量生效 ``` [hadoop@localhost local]$ source ~/.bashrc ``` **4、修改配置文件** 进入配置文件目录 ``` [hadoop@localhost local]$ cd $HADOOP_HOME/etc/hadoop ``` 修改下列配置文件 + hadoop-env.sh 修改文件中的JAVA_HOME ``` export JAVA_HOME=/usr/local/jdk1.8.0_241 ``` + core-site.xml 修改core-site.xml文件当中的 ```xml <configuration> </configuration> ``` 修改为 ```xml <configuration> <property> <name>hadoop.tmp.dir</name> <value>/usr/local/hadoop-2.8.5/tmp</value> <description>Abase for other temporary directories.</description> </property> <property> <name>fs.defaultFS</name> <value>hdfs://hadoopserver:9000</value> </property> </configuration> ``` + hafs-site.xml 同样修改为 ```xml <configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>/usr/local/hadoop-2.8.5/tmp/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/usr/local/hadoop-2.8.5/tmp/dfs/data</value> </property> </configuration> ``` + yarn-site.xml 同样修改为 ```xml <configuration> <property> <name>yarn.resourcemanager.hostname</name> <value>hadoopserver</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration> ``` + mapred-site.xml 因为mapred-site.xml文件不存在,所以重命名mapred-site.xml.template文件即可 ``` [hadoop@localhost hadoop]$ mv mapred-site.xml.template mapred-site.xml ``` 然后修改为 ```xml <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration> ``` + slaves 修改为主机名 ``` [hadoop@localhost hadoop]$ mv slaves hadoopserver ``` ### 四、启动 第一次启动之前需要格式化HDFS ``` [hadoop@localhost hadoop]$ hdfs namenode -format [hadoop@localhost hadoop]$ start-yarn.sh ```  启动服务 ``` [hadoop@localhost hadoop]$ start-dfs.sh ```  启动成功后访问web页面 http://192.168.159.135:50070/

标签:

Hbase

,

Hadoop

非特殊说明,本博所有文章均为博主原创。

如若转载,请注明出处:

https://lilinchao.com/archives/1122.html

上一篇

Hbase存储结构

下一篇

CentOS7 Zookeeper安装教程

评论已关闭

栏目分类

随笔

2

Java

326

大数据

229

工具

31

其它

25

GO

47

NLP

4

标签云

Zookeeper

前端

随笔

Map

并发编程

栈

Eclipse

哈希表

工具

SpringCloud

Golang基础

数学

JavaWEB项目搭建

递归

DataWarehouse

Stream流

pytorch

Flink

Git

Quartz

锁

容器深入研究

DataX

Hadoop

Ubuntu

散列

Flume

Jquery

正则表达式

字符串

友情链接

申请

范明明

庄严博客

Mx

陶小桃Blog

虫洞

评论已关闭