李林超博客

首页

归档

留言

友链

动态

关于

归档

留言

友链

动态

关于

首页

大数据

正文

CentOS7安装Hadoop3.2集群

Leefs

2021-03-06 PM

1995℃

0条

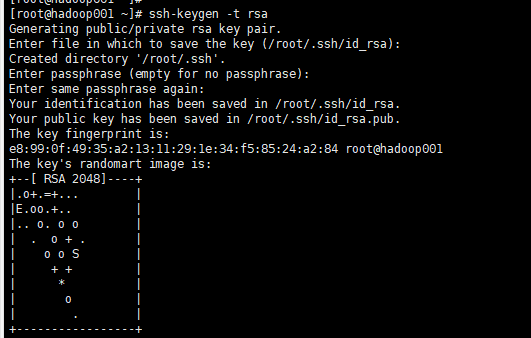

# 08.CentOS7安装Hadoop3.2集群 ### 前言 **虚拟机网络配置** 通过`ip addr`命令未查询到虚拟机IP地址 1、修改网络配置 ``` [root@localhost ~]# vi /etc/sysconfig/network-scripts/ifcfg-eno16777736 ``` 将ONBOOT=no改为ONBOOT=yes ONBOOT的意思是,开机时是否启动 2、重启网络服务 ``` [root@localhost ~]# service network restart ``` 3、查看IP地址 ``` [root@localhost ~]# ip addr ``` ### 一、Hadoop集群安装 #### 1. 系统环境 本次部署一个主节点,两个从节点 | 主机名称 | IP | 主节点 | | --------- | --------------- | ------ | | hadoop001 | 192.168.159.136 | √ | | hadoop002 | 192.168.159.137 | × | | hadoop003 | 192.168.159.138 | × | #### 2. 主机名设置 2.1 编辑网络配置文件 ``` [root@localhost ~]# vim /etc/sysconfig/network ``` 增加如下内容: ``` NETWORKING=yes HOSTNAME=hadoop001 ``` 2.2 永久设置主机名 ``` [root@localhost ~]# hostnamectl set-hostname hadoop001 ``` 2.3 重启 ``` [root@localhost ~]# reboot ``` 2.4 查看主机名是否生效 ``` [root@hadoop001 ~]# hostname ``` **hadoop002、 hadoop003的主机名配置与以上操作相同,主机名分别设为hadoop002、 hadoop003** #### 3. hosts文件配置 3.1 配置IP和hostname的映射关系 ``` [root@hadoop001 ~]# vim /etc/hosts ``` 增加以下内容: ``` 192.168.159.136 hadoop001 192.168.159.137 hadoop002 192.168.159.138 hadoop003 ``` hadoop002、hadoop003的hosts文件配置与以上操作相同 #### 4. 关闭防火墙 三台虚拟机都需要关闭 ``` [root@hadoop001 ~]# systemctl stop firewalld.service [root@hadoop001 ~]# systemctl disable firewalld.service ``` #### 5. ssh免密码登录 5.1 hadoop001虚拟机生成公钥,一路按回车就行 ``` [root@hadoop001 ~]# ssh-keygen -t rsa ```  5.2 向本机复制公钥 ``` cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys ``` 5.3 登录hadoop001验证 ``` [root@hadoop001 ~]# ssh hadoop001 ``` 第一次验证的时候会提示输入 yes 或 no, 输入了 yes 之后按回车可以进入就表示免密码登陆配置成功。  5.4 把公钥复制到另外两台虚拟机(需要输入对应的密码) ``` [root@hadoop001 ~]# ssh-copy-id -i hadoop002 [root@hadoop001 ~]# ssh-copy-id -i hadoop003 ``` 5.5 验证 在 hadoop100 机器上使用 ssh 命令确认集群免密码登陆是否设置成功, 如果可以免密码登陆进去就说明是没有问题的 ``` [root@hadoop001 ~]# ssh hadoop002 [root@hadoop001 ~]# exit [root@hadoop001 ~]# ssh hadoop003 [root@hadoop001 ~]# exit ``` #### 6. jdk安装 6.1 创建存放目录 ``` [root@hadoop001 source]# mkdir -p /data/soft/ [root@hadoop001 source]# cd /data/soft/ ``` hadoop002、hadoop003同样需要创建/data/soft目录 6.2 将jdk安装包上传到服务器 ``` [root@hadoop001 source]# rz ``` 6.3 解压,重命名 ``` [root@hadoop001 source]# tar -zxvf jdk-8u241-linux-x64.tar.gz -C /data/soft/ [root@hadoop001 source]# cd /data/soft/ [root@hadoop001 soft]# mv jdk1.8.0_241/ jdk1.8 ``` 6.4 配置环境变量 ``` [root@hadoop001 soft]# vim /etc/profile ``` 在文件末尾增加如下内容: ``` export JAVA_HOME=/data/soft/jdk1.8 export HADOOP_HOME=/data/soft/hadoop-3.2.1 export PATH=.:$JAVA_HOME/bin:$HADOOP_HOME/bin:$PATH ``` 6.5 刷新环境变量配置 ``` [root@hadoop001 soft]# source /etc/profile ``` 6.6 检查jdk是否安装成功 ``` [root@hadoop001 soft]# java -version ``` 6.7 复制Hadoop001的jdk以及环境变量到另外两台虚拟机 ``` [root@hadoop001 soft]# scp -rq /data/soft/jdk1.8/ hadoop002:/data/soft/ [root@hadoop001 soft]# scp -rq /etc/profile hadoop002:/etc/ [root@hadoop001 soft]# scp -rq /data/soft/jdk1.8/ hadoop003:/data/soft/ [root@hadoop001 soft]# scp -rq /etc/profile hadoop003:/etc/ ``` 6.8 分别切换到hadoop002、hadoop003,执行以下操作 ``` [root@hadoop002 source]# source /etc/profile [root@hadoop002 source]# java -version ``` #### 7. Hadoop安装 首先在 hadoop001 节点上安装,再复制到另外两台虚拟机。 7.1 下载 hadoop3.2.1下载地址:https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.2.1/hadoop-3.2.1.tar.gz 7.2 将下载好的hadoop安装包上传到服务器,解压 ``` [root@hadoop001 source]# rz [root@hadoop001 source]# tar -zxvf hadoop-3.2.1.tar.gz -C /data/soft/ ``` 7.3 修改Hadoop相关配置文件 + 进入配置文件所在目录 ``` [root@hadoop001 soft]# cd hadoop-3.2.1/etc/hadoop/ ``` + 修改 hadoop-env.sh 文件,增加环境变量信息 ``` [root@hadoop001 hadoop]# vim hadoop-env.sh ``` 在文件最后增加以下内容: ``` export JAVA_HOME=/data/soft/jdk1.8 export HADOOP_LOG_DIR=/data/hadoop_repo/logs/hadoop ``` + 修改 core-site.xml 文件 注意 fs.defaultFS 属性中的主机名需要和你配置的主机名保持一致 ``` [root@hadoop001 hadoop]# vim core-site.xml ``` 增加以下内容 :(注意文件中已经有“configuration”标签) ```xml <configuration> <property> <name>fs.defaultFS</name> <value>hdfs://hadoop001:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/data/hadoop_repo</value> </property> </configuration> ``` + 修改 hdfs-site.xml 文件, 把 hdfs 中文件副本的数量设置为2 ``` [root@hadoop001 hadoop]# vim hdfs-site.xml ``` 增加如下内容: ```xml <configuration> <property> <name>dfs.replication</name> <value>2</value> </property> <property> <name>dfs.namenode.secondary.http-address</name> <value>hadoop001:50090</value> </property> </configuration> ``` + 修改 mapred-site.xml, 设置 mapreduce 使用的资源调度框架 ``` [root@hadoop001 hadoop]# vim mapred-site.xml ``` 增加如下内容: ``` <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration> ``` + 修改 yarn-site.xml, 设置 yarn 上支持运行的服务和环境变量白名单 ``` [root@hadoop001 hadoop]# vim yarn-site.xml ``` 增加如下内容: ```xml <configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.env-whitelist</name> <value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CL ASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value> </property> <property> <name>yarn.resourcemanager.hostname</name> <value>hadoop001</value> </property> </configuration> ``` + 修改 workers 文件, 增加所有从节点的主机名, 一个一行 ``` [root@hadoop001 hadoop]# vim workers ``` **先删掉workers 文件原有的localhost**,增加以下内容: ``` hadoop002 hadoop003 ``` + 修改启动脚本 ``` [root@hadoop001 hadoop]# cd /data/soft/hadoop-3.2.1/sbin/ ``` + 在start-dfs.sh,stop-dfs.sh增加以下内容: ``` HDFS_DATANODE_USER=root HDFS_DATANODE_SECURE_USER=hdfs HDFS_NAMENODE_USER=root HDFS_SECONDARYNAMENODE_USER=root ```  + 在start-yarn.sh,stop-yarn.sh增加以下内容: ``` YARN_RESOURCEMANAGER_USER=root HADOOP_SECURE_DN_USER=yarn YARN_NODEMANAGER_USER=root ``` 7.4 格式化namenode ``` [root@hadoop001 hadoop-3.2.1]# cd /data/soft/hadoop-3.2.1/ [root@hadoop001 hadoop-3.2.1]# bin/hdfs namenode -format ``` 成功界面:  注意:如果多次格式化,需要先删除虚拟机的/data/hadoop_repo目录(core-site.xml 文件中设置的目录),再格式化才能成功。 7.5 启动集群 在 hadoop001 节点上执行 ``` [root@hadoop001 hadoop-3.2.1]# sbin/start-all.sh ```  7.6 验证集群 分别在三台虚拟机上运行命令:**jps** hadoop001结果 > [root@hadoop001 hadoop-3.2.1]# jps > 3635 NameNode > 4116 ResourceManager > 4250 Jps > 3853 SecondaryNameNode hadoop002结果 > [root@hadoop002 source]# jps > 12400 NodeManager > 12292 DataNode > 12490 Jps hadoop003结果 > [root@hadoop003 source]# jps > 12488 Jps > 12395 NodeManager > 12287 DataNode + 还可以通过 webui 界面来验证集群服务是否正常,在这三台虚拟机中任意的浏览器访问: hdfs webui 界面: http://192.168.159.136:9870  yarn webui 界面: http://192.168.159.136:8088

标签:

Hadoop

,

Spark

非特殊说明,本博所有文章均为博主原创。

如若转载,请注明出处:

https://lilinchao.com/archives/1207.html

上一篇

CentOS7 Spark Local模式搭建

下一篇

Zookeeper集群环境搭建

评论已关闭

栏目分类

随笔

2

Java

326

大数据

229

工具

31

其它

25

GO

47

NLP

4

标签云

字符串

并发编程

Scala

Spark Core

Livy

高并发

Java工具类

容器深入研究

Golang

JavaWeb

RSA加解密

Jquery

Yarn

Spring

Kibana

工具

Shiro

FastDFS

JavaScript

Docker

排序

查找

链表

Netty

Spark

持有对象

ajax

LeetCode刷题

HDFS

Eclipse

友情链接

申请

范明明

庄严博客

Mx

陶小桃Blog

虫洞

评论已关闭